lda что это значит тойота

Ошибка AHB и LDA

Всем доброго✌🏻день ото дня ненависть к тойоте растёт все больше. На этот раз выскочила ошибка проверьте систему AHB & LDA (за рулем была жена, говорит что ниче не делала ). Кто сталкивался? Как лечить? Глянул этот датчик с камерой на экзисте, стоит сто тыщ😒

Toyota RAV4 2013, двигатель дизельный 2.2 л., 150 л. с., полный привод, автоматическая коробка передач — поломка

Машины в продаже

Toyota RAV4, 2018

Toyota RAV4, 2015

Toyota RAV4, 2018

Toyota RAV4, 2018

Комментарии 16

у меня ошибки появились после замены лобового на китайское. AHB отвечает за автоматическое переключение ближнего/дальнего света, LDA следит за разметкой. Покупать датчик не вижу смысла, системы не критичные, но сообщения об ошибке постоянно висят на приборке и раздражают. Буду думать, как их убрать.

Я вкурсе че за че отвечает. Лоб и у меня заменен. Просто лоб заменён в январе, а ошибка вылетела весной. Все системы до этого работали.

привет, удалось победить ошибки AHB и LBA?

Привет. Нет не решил. Думал дело в датчике, его проверили все ОК. Думаю какой то сбой программный, но до официалов так и не доехал пока.

Вчера забрал машину после установки ГБО, и сразу обратил внимание, что ошибка AHB пропала. Спрашиваю установщика, мол, что делали? Ничего, говорит, только полночи машина простояла с откинутой клеммой аккумулятора.

Видимо, ошибка AHB как-то сбросилась, но LDA как бесила, так и продолжает бесить.

В бардачке машины нашел блок от оригинального стекла, решил поставить его вместо китайского датчика. Отсоединил провода, снял, а оригинал не встает — разъемы разные.

Оставлял я с откинутой клемой тоже, не помогло😂

Лда это же Камера на лобовом, там вроде как оригинальная Камера стоит никаких китайских и левых блоков🤔

Причин много может быть (у меня было года три назад, задолбало).

В машине всё нормально,

всему виной человек.

В электронику вмешивались?

Вижу, что да( читая прошлый пост про чип тюнинг, и судя по фоткам про замену магнитоллы).

Для начало вот :

www.drive2.ru/l/7956315/

Причину скорее всего нужно искать в мешательстве человека в электронику.

У машины всё продумано,

но машина не любит когда вмешиваются.

А кастрюля как-то в натуре стрёмно звучит,

хотя хозяин барин, мне тут тоже херьню писали.

Пиши, спрашивай, не стесняйся, отвечу.

Ну чип был больше месяца назад уже, и вмешивались в блок двигателя, лоб менян в январе (люди на форумах пишут что после замены лба) но 5 месяцев она проездила каким то образом, магнитолла судя по н/з была заменена в 16 году.

Твою запись на форуме видел, но ещё не испробовал ✌🏻

P.S.

Причину нужно искать в инородном вмешательстве, с машиной японцы всё продумали для людей.

Ещё проверьте аккумулятор, тоже бывает и такое, проверьте обязательно специальным прибором:

www.drive2.ru/l/5358397/

Как корабль назовешь, так он и поплывет. Поэтому убирай название кастрюля. Вон Пётр Хазаром назвал и норм)

Кастрюля только из-за цвета, хотя сейчас понимаю что походу не только из-за него😂😂😂😂

Тем более серебро самый практичный и лёгкий в уходе цвет…

Авто нужно любить, а не обзывать кастрюлей.

Шпаргалка. Сводная информация по машине

Решил сделать страничку со всей полезной информацией по машине в одном месте.

Буду пополнять по тихой.

Краткий список:

1. Полная инструкция по авто на Русском (перевод автоматом)

2. Система иммобилайзера

3. Индикация на приборной панели

4. Где номер двигателя и номер кузова

5. Как прикурить гибрид

6. Как поменять резинки на дворниках

7. Описание электронных систем авто

8. О высоте подголовников

9. Как зафиксировать сложенный 2 ряд сидушек

10. Описание передач

11. Что такое ECO Mode

12. Автоматический дальний свет

13. Где расположены датчики автомобиля

14. … не придумал 🙂

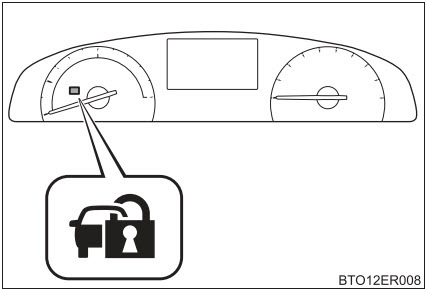

2. Система иммобилайзера

Эта система способствует предотвращению угонов транспортных средств и всех краж транспортных средств.

Ключ имеет встроенный передатчик сигнала. Ключ предварительно зарегистрирован в машине.

Невозможно запустить гибридную систему без наличия ключа.

• Когда машина заглушена и питание выключено, достаточно отойти от машины с ключом и включится блокировка, на табло отображается Индикатор безопасности, он мигает.

• Когда владелец садится в машину с зарегистрированным ключом, система иммобилайзера отключается и Индикатор безопасности выключается.

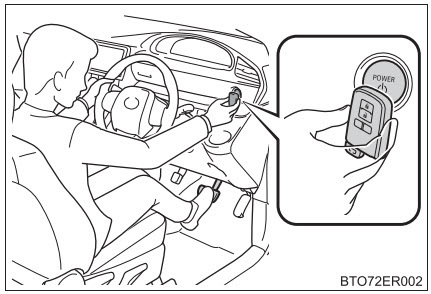

ВНИМАНИЕ! Если села батарейка в брелке, можете попробовать нажать кнопку «Power» автомобиля брелком. Есть индукционная наводка которая позволяет узнать брелок машиной и машина заведется.

3. Индикация на приборной панели

Оформлю позже…

4. Где номер двигателя и номер кузова

Номер кузова расположен как обычно под водительским сидением.

Номер двигателя расположен в хитром месте, но видя картинку найти достаточно просто.

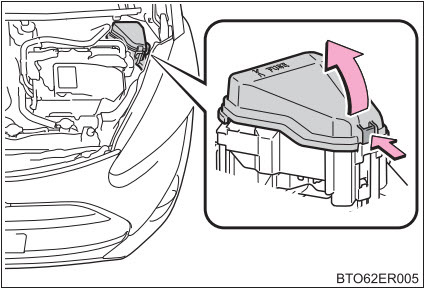

5. Как прикурить гибрид

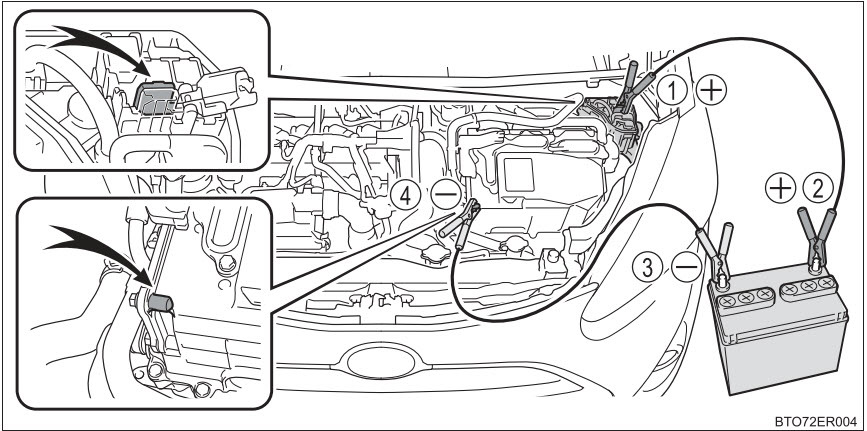

Гибрид не запустится с севшим аккумулятором ДВС который находится в багажнике. Его можно снять и зарядить, а можно прикурить как обычно, для этого необходимо:

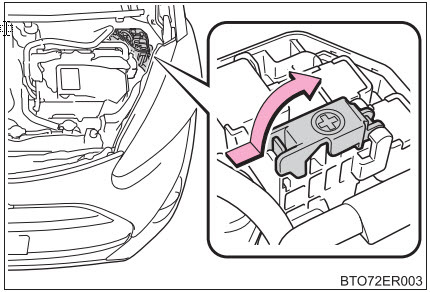

— открыть капот;

— открыть крышку блока предохранителей;

— открыть крышку «+» контакта;

— крокодилы провода кинуть на «+» и на массу авто;

— прикурить от пускового устройства, другой машины или от аккумулятора;

— на экране табло должна загорется надпись «Ready» которая говорит что машина завелась от ВВБ;

— пойдет заряд малого аккумулятора, можно ехать сразу не ожидая зарядки;

— для нормального заряда достаточно проехать 30 мин или примерно 15 км.

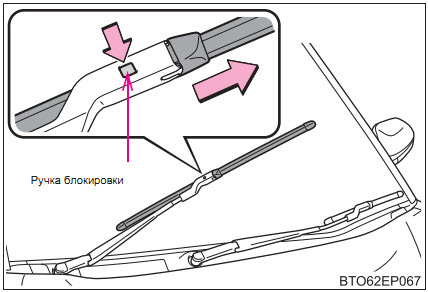

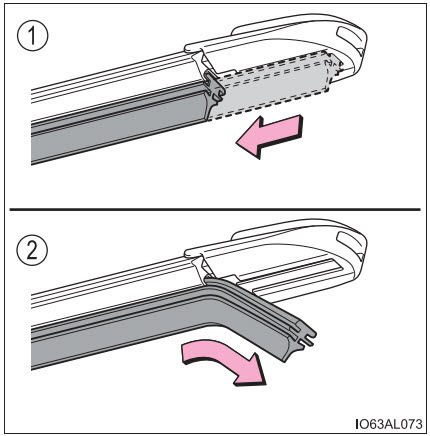

6. Как поменять резинки на дворниках

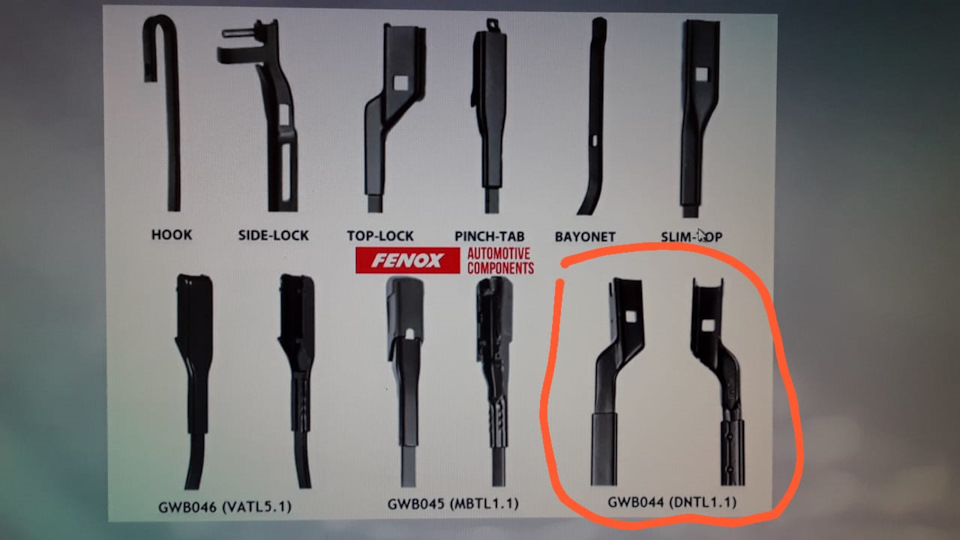

Корпуса у дворников достаточно хорошие и смысла менять их каждый раз не вижу смысла.

Тем более что у нас конструкция дворников не сильно распространенная

У производителя написана процедура замены резинок в дворниках, конструкция предназначена для этого.

Геометрия резинок видна на рисунке, ширина 8 мм длина 650мм и 350мм.

1. Снять дворники, конструкция достаточно удобная, просто нажать кнопку.

2. Сдвинуть резинку в сторону и вытащить, снять металлические ребра жесткости.

3. В новую резинку вставить железные ребра жесткости и установить по обратной процедуре.

Для легкости установки можно смазать мыльным раствором.

7. Описание электронных систем авто

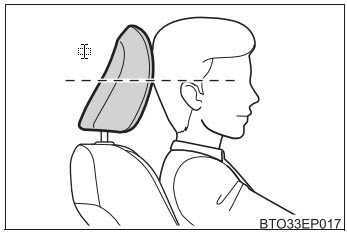

8. О высоте подголовников

Центр подголовника должен находится на уровне верхней части ушей.

Требования безопасности и эргономики.

Никогда про такое не задумывался 🙂

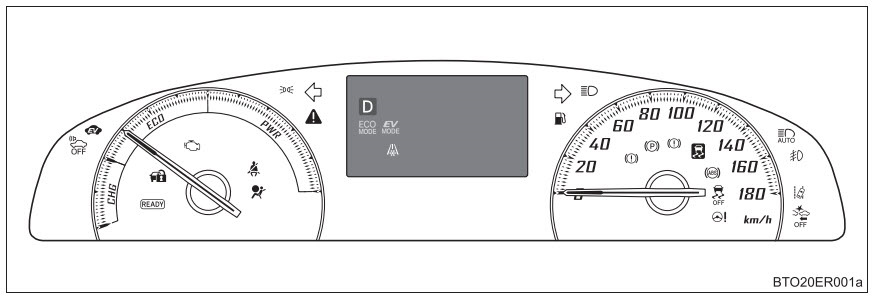

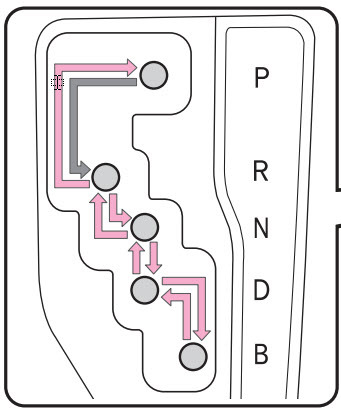

10. Описание передач

Как таковых передач в Синте нет. Планетарный двигатель не имеет передач, технология совсем другая и вы может замечали, что нет дерганий переключения совсем.

Но стандарт и привычки людей диктует формат переключения передач.

P — «Parking» парковка, в этом положении выходной вал заблокирован. Должна автоматически отключаться электрика через 20 мин после выключения двигателя и закрытия машины, для предотвращения разряда аккумулятора;

R — «Reverse» задний ход, самое интересное, что задний ход работает только от ДВС у гибридной установки движуха только вперед;

N — нейтральное положение, двигатель и колеса разъединены. Колеса сами по себе. Когда рычаг переключения передач находится в положении N, аккумуляторная батарея не заряжается, даже если бензиновый двигатель работает. Если оставить N со включенной электрикой в течение длительного времени, даже при включенном двигателе есть шанс посадить аккумулятор;

D — «Drive» движение вперед, это одна и единственная передача;

B — таже самая передача D но особенность в торможении. Торможение двигателем, используется при затяжном торможении при спуске с горок или горных серпантинов. Рекуперация уходит на второй план, активнее подключаются тормозные колодки.

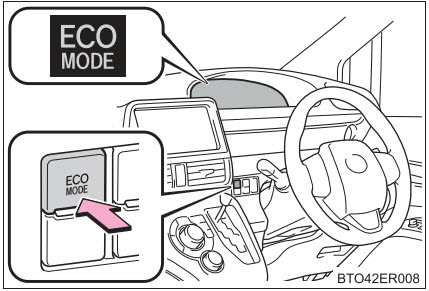

11. Что такое ECO Mode

Для включения/выключения необходимо нажать кнопку «ECO Mode» на панели.

Режим не отключается при выключении двигателя.

По сравнению с обычным режимом, крутящий момент двигателя меньше при нажатии педали акселератора, получается автомобиль притупляет резкий скачек оборотов при нажатии педали газа.

Также подавляет работу кондиционера (обогрев / охлаждение) для повышения эффективности использования топлива.

Режим для спокойной езды, педаль газа становится немного «ватной» и чтобы ускорится надо хорошенько продавить педаль газа.

Сильной разницы в динамике движения по городу я не заметил, на трассе для частых обгонов можно отключить.

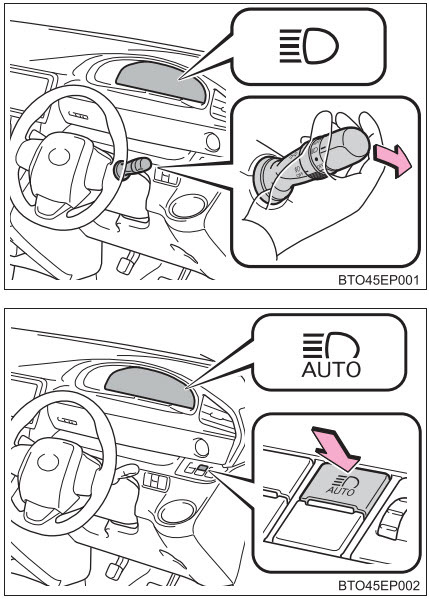

12. Автоматический дальний свет

Достаточно удобная функция в дальних дорогах, можно совершенно не заботиться о переключении дальнего света на трассе, машина сама все сделает. Волшебство 🙂

Как это работает: горит дальний свет, датчики определяют встречный свет и автоматически переключают свет фар на ближний, проезжаем машину, опять встречного света нет и автоматически включается дальний свет фар.

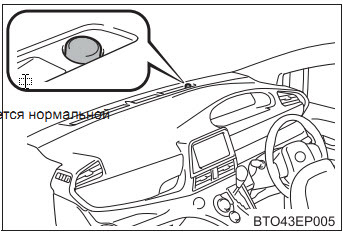

13. Где расположены датчики автомобиля

Датчик света.

Определяет освещенность на улице и управляет авто включением фар, габаритов если на кулисе переключения фар выставлено «AUTO». Если закрыть датчик, постоянно будут сумерки для машины.

Находятся за зеркалом заднего вида. Нельзя закрывать, реально глаза машине закроете.

Желательно держать лобовое стекло в чистоте в этом месте.

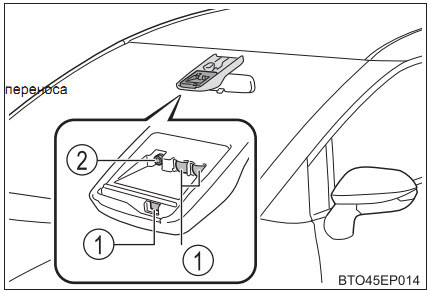

1. Лазерный датчик движения, использует лазерный свет для обнаружения впереди идущего автомобиля и препятствий;

2. Монокулярная камера;

Предназначены для:

PCS (система безопасности перед столкновением)

LDA (предупреждение о выезде с полосы движения)

…может для фотографирования параметров при ДТП

…скорее всего еще есть функционал, не нашел информацию.

Запускаем LDA в реальном мире. Подробное руководство

Предисловие

На просторах интернета имеется множество туториалов объясняющих принцип работы LDA(Latent Dirichlet Allocation — Латентное размещение Дирихле) и то, как применять его на практике. Примеры обучения LDA часто демонстрируются на «образцовых» датасетах, например «20 newsgroups dataset», который есть в sklearn.

Особенностью обучения на примере «образцовых» датасетов является то, что данные там всегда в порядке и удобно сложены в одном месте. При обучении продакшн моделей, на данных, полученных прямиком из реальных источников все обычно наоборот:

Исторически, я стараюсь учиться на примерах, максимально приближенных к реалиям продакшн-действительности потому, что именно таким образом можно наиболее полно прочувстовать проблемные места конкретного типа задач. Так было и с LDA и в этой статье я хочу поделиться своим опытом — как запускать LDA с нуля, на совершенно сырых данных. Некоторая часть статьи будет посвящена получению этих самых данных, для того, чтобы пример обрел вид полноценного ‘инженерного кейса’.

Topic modeling и LDA.

Для начала, рассмотрим, что вообще делает LDA и в каких задачах используется.

Наиболее часто LDA применяется для Topic Modeling(Тематическое моделирование) задач. Под такими задачами подразумеваются задачи кластеризации или классификации текстов — таким образом, что каждый класс или кластер содержит в себе тексты со схожими темами.

Для того, чтобы применять к датасету текстов(далее корпус текстов) LDA, необходимо преобразовать корпус в term-document matrix(Терм-документная матрица).

Терм-документная матрица — это матрица которая имеер размер , где

N — количество документов в корпусе, а W — размер словаря корпуса т.е. количество слов(уникальных) которые встречаются в нашем корпусе. В i-й строке, j-м столбце матрицы находится число — сколько раз в i-м тексте встретилось j-е слово.

LDA строит, для данной Терм-документной матрицы и T заранее заданого числа тем — два распределения:

Значения ячеек данных матриц — это соответственно вероятности того, что данная тема содержится в данном документе(или доля темы в документе, если рассматривать документ как смесь разных тем) для матрицы ‘Распределение тем по текстам’.

Для матрицы ‘Распределение слов по темам’ значения — это соотв-но вероятность встретить в тексте с темой i слово j, качествено, можно рассматривать эти числа как коэффициенты характеризующие, то насколько данное слово характерно для данной темы.

Следует сказать, что под словом тема понимается не ‘житейское’ определение этого слова. LDA выделяет T тем, но что это за темы и соответствуют ли они каким-либо известным темам текстов, как например: ‘Спорт’, ‘Наука’, ‘Политика’ — неизвестно. В данном случае, уместно скорее говорить о теме, как о некой абстрактной сущности, которая задается строкой в матрице распределения слов по темам и с некоторой вероятностью соответствует данному тексту, если угодно можно представить ее, как семейство характерных наборов слов встречающихся вместе, с соответствующими вероятностями(из таблицы) в некотором определенном множестве текстов.

Если вам интересно более подробно и ‘в формулах’ изучить как именно обучается и работает LDA, то вот некоторые материалы(которые использовались автором):

Добываем дикие данные

Для нашей ‘лабораторной работы’, нам понадобится кастомный датасет со своими недостатками и особенностями. Добыть его можно в разных местах: выкачать отзывы с Кинопоиска, статьи из Википедии, новости с какого-нибудь новостного портала, мы возьмем чуть более экстремальный вариант — посты из сообществ ВКонтакте.

Делать это мы будем так:

Инструменты и статьи

Для выкачивания постов будем использовать модуль vk для работы с API ВКонтакте, для Python. Один из наиболее замысловатых моментов при написании приложения с использованием API ВКонтакте — это авторизация, к счастью, код выполняющий эту работу уже написан и есть в открытом доступе, кроме vk я использовал небольшой модуль для авторизации — vkauth.

Ссылки на используемые модули и статьи для изучения API ВКонтакте:

Пишем код

И так, с помощью vkauth, авторизируемся:

В процессе, был написан небольшой модуль содержащий все необходимые для выгрузки контента в соответствующем формате функции, ниже они преведены, давайте пройдемся по ним:

Итоговый пайплайн имеет следующий вид:

Fails

В целом, сама по себе процедура выкачивания данных не представляет собой ничего трудного, обратить внимание следует лишь на два момента:

При совершении большого количества запросов, например в цикле, мы так же будем ловить ошибки. Эту проблему можно решить несколькими способами:

В данной работе был выбран простой и медленный способ, в дальнейшем, я возможно напишу микростатью про способы обхода или ослабления ограничений на количество запросов в секунду.

С затравочным ‘некоторым’ пользователем имеющим

150 друзей, удалось добыть 4679 текстов — каждый характеризует некоторое сообщество ВК. Тексты сильно варьируются по размеру и написаны на многих языках — часть из них не пригодна для наших целей, но об этом мы поговорим чуть дальше.

Основная часть

Пройдемся по всем блокам нашего пайплайна — сначала, по обязательным(Идеально), затем по остальным — они, как раз и представляют наибольший интерес.

CountVectorizer

Перед тем, как учить LDA, нам необходимо представить наши документы в виде Терм-документной матрицы. Это обычно включает в себя такие операции как:

Все эти действия в sklearn удобно реализованы в рамках одной программной сущности — sklearn.feature_extraction.text.CountVectorizer.

Все, что нужно сделать это:

Аналогично с CountVectorizer`ом, LDA, прекрасно реализовано в Sklearn и других фреймворках, поэтмому уделять непосредственно их реализациям много места, в нашей, сугубо практической статье нет особого смысла.

Все, что нужно, чтобы запустить LDA это:

Preprocessing

Если мы просто возьмем наши тексты сразу после того как скачали их и конвертируем в Терм-документную матрицу с помощью CountVectorizer, со встроеным дефолтным токенайзером, мы получим матрицу размера 4679×769801(на используемых мной данных).

Размер нашего словаря будет составлять 769801. Даже если допустить, что большая часть слов информативны, то мы все равно вряд ли получим хороший LDA, нас ждет что-то вроде ‘Проклятия размерностей’, не говоря уже о том, что практически для любого компьютера, мы просто забьем всю оперативную память. На деле, большя часть этих слов совершенно не информативны. Огромная часть из них это:

Кроме того, многие группы в ВК специализируются исключительно на изображениях — там почти нет текстовых постов — тексты соответствующие им вырождены, в Терм-документной матрице они будут давать нам практически полностью нулевые строки.

И так, давайте же отсортируем это все!

Токенизируем все тексты, уберем из них пунктуацию и числа, посмотрим на гистограмму распределения текстов по количеству слов:

Уберем все тексты размером меньше 100 слов(их 525)

Теперь словарь:

Удаление всех лексем(слова) состоящих не из букв, в рамках нашей задачи — это вполне допустимо. CountVectorizer делает это сам, даже если нет, то думаю здесь не нужно приводить примеров(они есть в полной версии кода к статье).

Одной из наиболее распространенных процедур по уменьшению размера словаря является удаление так называемых stopwords(стопворды) — слов не несущих смысловой нагрузки или/и не имеющих тематической окрашенности(в нашем случае — Topic Modeling же). Такими словами в нашем случае являются, например:

В модуле nltk есть сформированные списки стопвордов на русском и на английском, но они слабоваты. В интернете можно найти еще списки стопвордов для любого языка и добавить их к тем, что есть в nltk. Так мы и сделаем. Возьмем дополнительно стопворды отсюда:

На практике, при решении конкретных задач списки стопвордов постепенно корректируются и дополняются по мере обучения моделей, так как для каждого конкретного датасета и задачи существуют свои конкретные ‘несодержательные’ слова. Мы тоже подберем себе кастомных стопвордов после обучения нашего LDA ‘первого поколения’.

Сама по себе процедура удаления стопвордов встроена в CountVectorizer — нам только нужен их список.

Достаточно ли того, что мы сделали?

Большинство слов которые находятся в нашем словаре по-прежнему не слишком информативны для обучения на них LDA и не находятся в списке стопвордов. Поэтому применим к нашим данным еще один способ фильтрации.

, где

t — слово из словаря.

D — корпус(множество текстов)

d — один из текстов корпуса.

Посчитаем IDF всех наших слов, и отсечем слова с самым большим idf(очень редкие) и с самым маленьким(широкораспространенные слова).

Полученный после вышеописанных процедур уже вполне пригоден для обучения LDA, но произведем еще стемминг — в нашем датасете часто встречаются одни и те же слова, но в разных падежах. Для стемминга использовался pymystem3.

После применения вышеописанных фильтраций размер словаря уменьшился с 769801 до

13611 и уже с такими данными, можно получить LDA модель приемлимого качества.

Тестирование, применение и тюнинг LDA

Теперь, когда у нас есть датасет, препроцессинг и модели которые мы обучили на обработаном датасете, хорошо было бы проверить адекватность наших моделей, а так же соорудить для них какие-нибудь приложения.

В качестве приложения, для начала рассмотрим задачу генерации ключевых слов для данного текста. Сделать это в достаточно простом варианте можно следующим образом:

Напишем простой класс-интерфейс который и будет реализовывать данный способ генерации ключевых слов:

Применим наш метод к нескольким текстам и посмотрим что получается:

Cообщество: Агентство путешествий «Краски Мира»

Ключевые слова: [‘photo’, ‘social’, ‘travel’, ‘сообщество’, ‘путешествие’, ‘евро’, ‘проживание’, ‘цена’, ‘польша’, ‘вылет’]

Cообщество: Food Gifs

Ключевые слова: [‘масло’, ‘ст’, ‘соль’, ‘шт’, ‘тесто’, ‘приготовление’, ‘лук’, ‘перец’, ‘сахар’, ‘гр’]

Результаты выше не ‘cherry pick’ и выглядят вполне адекватно. На деле, это результаты из уже настроенной модели. Первые LDA, которые были обучены в рамках этой статьи выдавали существенно более плохие результаты, среди ключевых слов можно было часто увидеть, например:

Настройка(тюнинг) модели производился следующим образом:

Подобную ‘чистку’, следует проводить аккуратно, предварительно просматривая, те самые 10% слов. Скорее, так следует выбирать кандидатов на удаление, а после уже в ручную отбирать из них слова которые следует удалить.

Где-то на 2-3 поколении моделей, с подобным способом отбора стопвордов, для топ-5% широкораспространенных топ-слов распределений мы получаем:

[‘любой’, ‘полностью’, ‘правильно’, ‘легко’, ‘следующий’, ‘интернет’, ‘небольшой’, ‘способ’, ‘сложно’, ‘настроение’, ‘столько’, ‘набор’, ‘вариант’, ‘название’, ‘речь’, ‘программа’, ‘конкурс’, ‘музыка’, ‘цель’, ‘фильм’, ‘цена’, ‘игра’, ‘система’, ‘играть’, ‘компания’, ‘приятно’]

Еще приложения

Первое, что приходит в голову конкретно мне — это использовать распределения тем в тексте как ‘эмбеддинги’ текстов, в такой интерпретации можно применять к ним алгоритмы визуализации или кластеризации, и искать уже итоговые ‘эффективные ‘ тематические кластеры таким образом.

На выходе, мы получим следующего вида картинку:

Крестики — это центры тяжести(cenroids) кластеров.

На изображении tSNE ембеддингов, видно, что кластеры выделенные с помощью KMeans, образуют достаточно связные и чаще всего пространственно разделимые между собой множества.