non indexable что это значит

Indexed Pages

Главная суть

Реальное количество индексируемых страниц можно получить путем парсинга сайта с настройками краулера приближенными к поисковым системам.

Формула

Частный случай

В идеале

Но к такому значению можно приблизиться за счет улучшения показателя Tr-Pages,% => 100%.

От куда брать данные?

Google Search Console

«Индекс» => «Покрытие» => Таб «Страница без ошибок» (таб «Без ошибок, есть предупреждения» также можно учитывать, но можно списать на погрешность) => можно посмотреть значение на определенный день (отображаются данные за последние 3 месяца).

Альтернатива. Поиск Google

Минус подхода: смотрим данные на текущий момент.

Результаты являются значением GIndex-Pages или Index-Pages (если принимаем данное количество за истину).

Яндекс.Вебмастер

«Индексирование» => «Страницы в поиске» => смотрим количество страниц на определенную дату.

Отчет «Страницы в поиске» в вебмастере Яндекс.

Альтернатива. Поиск Яндекс

Используем аналогично оператор host:hostname.ru | host:www.hostname.ru

Минус подхода: смотрим данные на текущий момент.

Результаты являются значением YIndex-Pages или Index-Pages (если принимаем данное количество за истину).

Инструменты Netpeak Spider или Screaming Frog SEO Spider

Тут важно задать правильные настройки сканирования, аналогично краулерам поисковиков.

Учет файла robots.txt, директивы meta robots noindex, соблюдение тега Canonical, следование редиректам и т.п. Так же желателен учет Sitemap. Это всё делается с целью поиска всех возможных url.

Netpeak Spider

Сканируем сайт с необходимыми настройками и получаем значение («Индексируемые URL«):

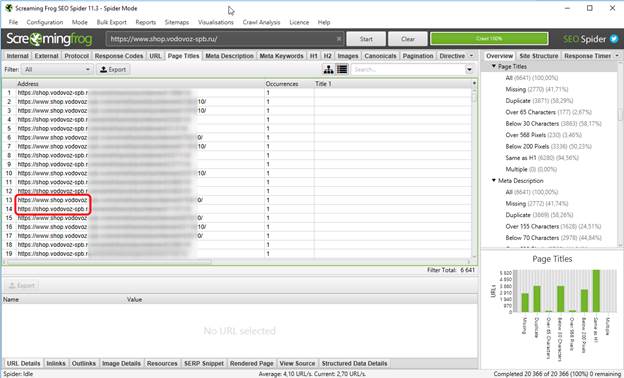

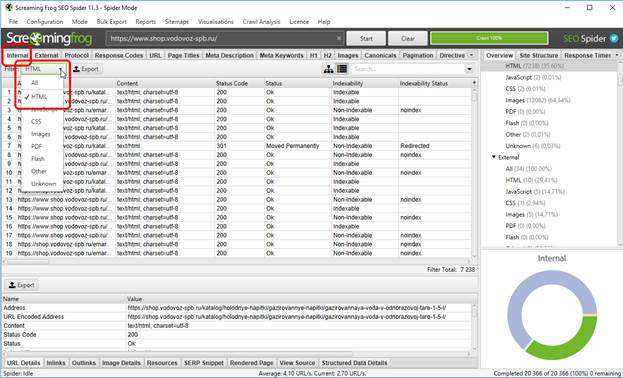

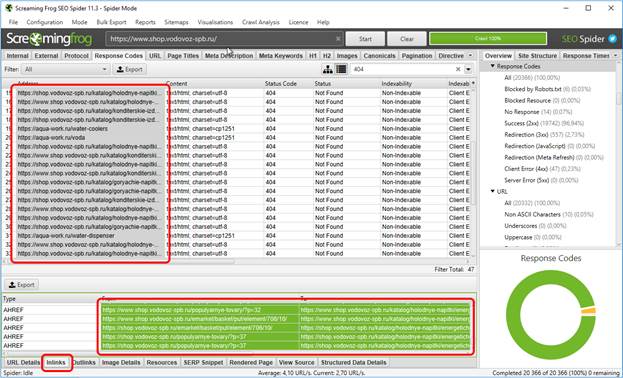

Screaming Frog SEO Spider

Т.е. считаем количество HTML-контент со значением «Indexable«:

После парсинга сайта отбираем индексируемые HTML-страницы отдающие код 200. Количество таких страниц является истинным значением Index-Pages.

Вместо заключения

Оценка индекса позволяет выявить проблемы индексации, определить текущий потенциал сайта.

Non-Indexable Pages

Non-indexable pages are pages that cannot be indexed by Google, in terms of the checks we perform these are pages that either have a noindex tag present and / or are disallowed from the robots.txt file.

Use this data to make sure that the content you want to be indexed can be indexed. Check out the video below for a short summary of what crawl data means.

Why Are URLs Not Indexable

There are several reasons why a page is not indexable, we cover all of these in this section. Pages that were once indexed but have had something implemented to prevent them from being indexed may take some time to be deindexed. Google needs to crawl a page or find a file and determine that it has changed before removing from its index.

NOINDEX TAG (Meta Robots Tag)

A meta robots tag is a page level tag that is added the head section of the source code … and these control aspects of indexation among other things. Adding a noindex meta robots tag to a page with prevent Google from indexing the page. They do however have to crawl the page to identify the tag.

The no index tag looks like this:

To prevent only Google web crawlers from indexing a page, you use the following met robots tag:

Disallow in Robots.txt

The robots.txt file primarily controls which content should be crawled by search engines and robots. This is not always obeyed by all web crawlers, but Google typically will obey this file. You can see an example of this on our site here robots.txt

The robots.txt file is just a plain text just file, the format for disallow looks like this:

User-agent: [user-agent name]

Disallow: [URL you don’t want crawled]

The specific code for preventing search engines and crawlers from crawling components of your site looks like this:

User-agent: googlebot

Disallow: /directory/page/

There are also many ways to manage this such as using wildcards to prevent any content with a file extension from being indexed.

Canonical Tag (Non-Canonical Page)

Canonical tags determine the canonical or preferred version of content, this is often when content is accessible from multiple URLs and you want to stipulate which is the right one. You can also use a canonical tag to reference another page if that page has been largely or completely copied.

Non-canonical pages, which are pages that have a canonical tag link that references another URL are unlikely to be indexed by Google bit this is not always the case. A canonical tag looks like this:

Redirects

There are several redirections such as permanent or temporary but in either case the page is inaccessible and as such will not be indexed by Google. Google will typically index the page being redirected to if that page is indexable.

Inaccessible Pages

Although we just mentioned redirects which are inaccessible, there are also pages which are inaccessible for other reasons such as pages that are broken. A page that returns a 404 status or a 5XX response code will not be indexed by Google because it cannot be accessed.

Flash Content

Flash content although rare nowadays will not be indexed by Google because they cannot read or understand it.

JavaScript Rendering

This is something which is becoming more indexable, but it can still cause the content to be non-indexable.

Content Behind a Login

If you have content that you sell or only want to give access to specific people, putting behind a paywall or a login. Unless the crawler has the login, credentials which Google will not, this content will be non-indexable. A good example of this are the SEO tools that we provide, you need to sign up for this, verify an email and make a password which you use to access the content. This means that all of the tools we have are not indexed by Google.

Why Use Non-Indexable Pages?

There are many reasons why a page is non-indexable. The first is accidental. Misapplying a tag or setting the contents of a tag incorrectly can result in content not being indexed.

Alternatively, you may have content that is used for pad landing pages for AdWords or native advertising, you many have a lot of duplicate content on your site or content accessible from multiple URLs. As such you may want to make this non-indexable to avoid other issues from Google such as duplicate content.

This guide is part of an extensive series of guides covering the data that we show in the summary tab of our SEO reporting feature. The following list of links shows all of the categories of data guides, videos and tutorials that we have. If you have any feedback on this or anything else, please fee free to get in touch:

Raptor is an SEO software provider, helping to automate as much of SEO as possible!

Indexable vs Non-Indexable Content: What is the Difference?

My Little Big Web / Search Engine Optimization (SEO) / Indexable vs Non-Indexable Content: What is the Difference?

When you make a query on a search engine, the order of web page results that appear is no coincidence. If you run a website or blog, you may at some point have become frustrated that your link was relegated to the third page.

Because, let’s be honest, how many users search beyond the first page? None. They never do.

For your site to be indexed on Google, Bing and other search engines, while also having a chance at overtaking your competitors, it needs to have visibility.

But, how do you get it out of the shadows and into the light? This process is called indexation.

Web crawlers: huh?!

As mentioned earlier, having indexable content is a necessary step for your site to be ranked among the top results. This is where web crawlers come into play.

Web crawlers provide search engines with useful information from the billions of sites on the internet. Their goal is to detect web pages and to “take note” of the subjects covered within them. This will allow your link to be indexed when a user types in your keyword or topic.

Despite their goodwill, robots are not infallible. They sometimes miss out on blogs or sites that are otherwise very interesting.

It is therefore essential to organize and develop your website so that it can be located and easily crawled by robots. In other words, to optimize it.

We often write about our hobby horse, natural referencing or SEO. And, of course, indexing is an integral part of this considerable undertaking.

Is this content indexable or not?

You no doubt understand that indexable content is much more valuable to you.

To ensure that your site is in the Google index, type: site: www.yoursite.com into the search bar. The number of results corresponds to the indexed pages of your website.

Now, how can you achieve a website that is properly detected and crawled by the search engines?

Indexable content

It is possible to ask Google to proceed with the indexation of your site, either by submitting a form or placing a link to your site on another site (backlinking). Of course, make sure that the site hosting your link is itself indexed!

Furthermore, the content must be authentic and unique. Much like at school, duplicating content is very negatively perceived by Google.

Another way to be noticed by crawlers is to add a custom TITLE tag. This is a particularly important step during the indexing process. The same goes for the META DESCRIPTION. Do not let the machine do it for you, at the risk that it won’t grab the attention of either the crawlers or your potential customers. Optimize them!

If you use images or videos, it is also necessary to improve them by filling in the title and description. Search engines are not yet able to recognize visual content, so they do not take it into account.

Think about it: if Google can’t detect the image subject (is it Barack Obama or a cat?), how then can it find the image when someone searches for the first black president of the United States?

Non-indexable content

Here are some examples of things that make it more difficult for crawlers to read content:

Content that is unindexable is found on what is called the deep web. Make sure your valuable data does not get stuck in this vast meandering space!

Final thoughts…

In other words, indexing is the process of detecting and analyzing your site that is performed by search engine robots.

If your content is unindexed, your page will not show up in searches, even if your info is the most relevant.

There are several solutions to getting your pages out of the hidden abyss of the internet, which usually comes down to optimizing your content. It’s not so surprising that content writing is in such high demand!

Content writers have the expertise to generate relevant content that is interesting for users and detectable by search engines. Provided, of course, you choose those that have the necessary experience!

Cofondatrice et Spécialiste SEO-SEM

Eugénie a commencé sa carrière en marketing Web chez Microsoft auprès de partenaires tels que Hewlett-Packard et Dell. En 2013, elle co-fonde My Little Big Web avec Maxence afin d’aider les PME à optimiser leur marketing Web. Ses compétences en SEO, publicité en ligne et expérience utilisateur permettent aux clients de My Little Big Web de se positionner rapidement et durablement en haut des résultats de recherche. Le partage de connaissances fait partie de ses priorités. Elle donne donc de nombreuses formations internes et externes ainsi que des conférences sur de multiples thèmes relatifs au marketing numérique.

Обзор Screaming Frog Seo Spider

Как Вы знаете, мы периодически публикуем обзоры на инструменты, которыми сами пользуемся (ярчайшие примеры – KeyCollector и KeyAssort). Пришло время рассказать про еще один такой мощнейший инструмент. Инструмент называется Screaming Frog Seo Spider. Данную программу можно использовать и бесплатно, но функционал в этом случае будет прилично так урезан.

Обзор на данную программу будет неполным, ибо мы расскажем только про тот функционал, который сами используем. Причем в основном мы используем данную программу при проведении аудитов. Также в этом обзоре нередко будет фигурировать Excel, т.к. именно там мы с помощью формул обрабатываем большие объемы данных буквально в 2 клика.

Запуск сканирования сайта

Ну тут нам ничего не остается, кроме, как просто включить «Капитана Очевидность» и сказать, что перед тем, как приступить к анализу каких-либо данных, эти данные необходимо сначала получить. Этим и займемся.

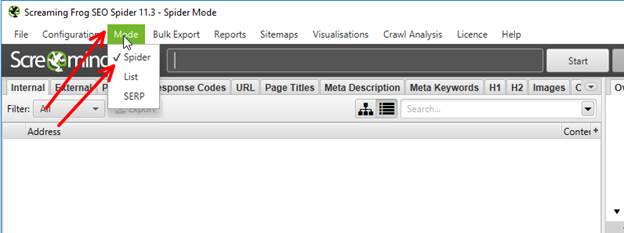

Первым делом заходим в меню Mode и ставим галочку Spider.

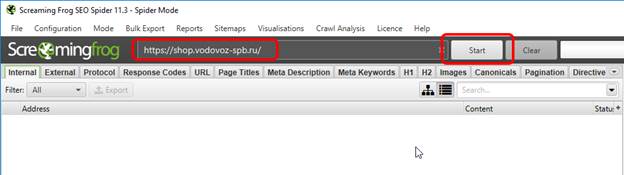

Далее указываем имя сайта и нажимаем Start.

Кстати, с недавних пор это наш клиент (мы про сайт). Разумеется, «весь аудит» мы не покажем, но большинство «основных моментов» все же рассмотрим.

Всё – осталось только дождаться, когда программа завершит сканирование сайта. Имейте в виду, что в бесплатном режиме можно просканировать не более 500 адресов. Хотя… Если сайт очень маленький, то вполне возможно, что в лимит Вы упрётесь нескоро.

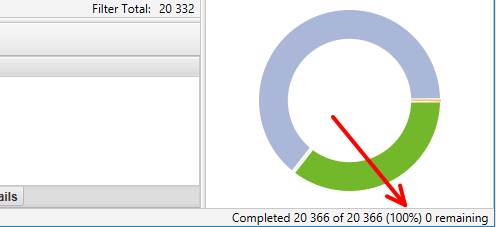

Как только сканирование будет окончено, в правом нижнем углу программы появится 100% и точное количество отсканированных адресов.

В данном случае их 20366, а это далеко за пределами «бесплатного» лимита. Итак, сканирование завершено. Ну а теперь переходим непосредственно к тому, какие данные мы обычно используем, как их анализируем и какие выводы из этого делаем.

Поиск дублей (как страниц, так и мета-тегов)

В контексте SEO «дублями» принято считать документы, которые доступны по разным адресам. Например, когда одна и та же карточка товара находится в двух разных разделах интернет-магазина и, как следствие, имеет 2 разных адреса.

Однако, в рамках данной статьи речь пойдет не только о дублях документов, но и о дублях мета-тегов. Поэтому давайте договоримся, что дубли страниц мы будем называть «документальными дублями», а дубли мета-тегов – просто «дублями».

По идее было бы логичнее рассказать отдельно про дубли и отдельно про документальные дубли. Но фишка в том, что методика их выявления абсолютно идентична. Более того, с помощью Screamшng Frog Seo Spider имеет смысл имеет смысл искать и то и другое, причем одновременно, чтобы сэкономить на этом кучу времени.

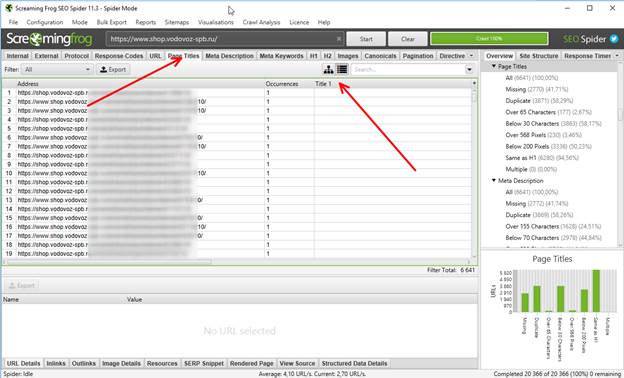

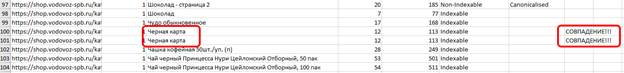

Итак, что мы знаем о документальных дублях? Правильно – у них всегда совпадают мета-теги. Следовательно, выбираем вкладку Page Titles и сортируем заголовки по алфавиту.

И вот тут мы видим сразу 2 косяка.

Во-первых, на сайте присутствуют страницы как с www., так и без. Следовательно, дубли на сайте присутствуют. Непорядок. Надо заносить эту информацию в аудит и ставить ТЗ на исправление.

Во-вторых, были обнаружены страницы, на которых Title и вовсе отсутствует. Однако, разобравшись, что это за страницы, вопросы отпали – это технические адреса, при посещении которых:

Следовательно, отсутствие заголовка Title в данном случае вполне допускается. Однако, все равно непонятно, имеются ли какие-либо косяки по Title или нет.

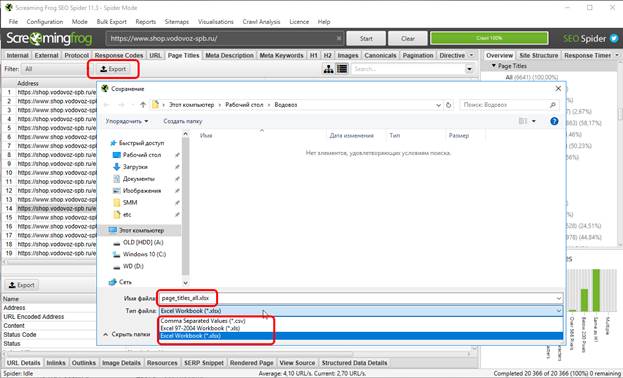

Что же делать? Правильно – экспортировать данные в Excel (кстати, в бесплатном режиме эта функция недоступна), для чего нажимаем на Export, даём имя файлу и выбираем желаемый для сохранения формат – текстовый (csv), либо Excel’евский, причем как старый, так и новый. Мы предпочитаем последний.

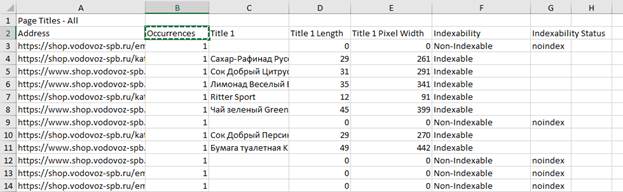

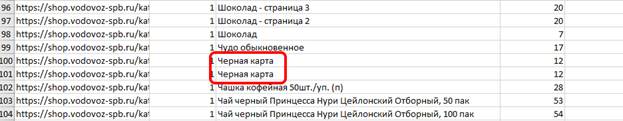

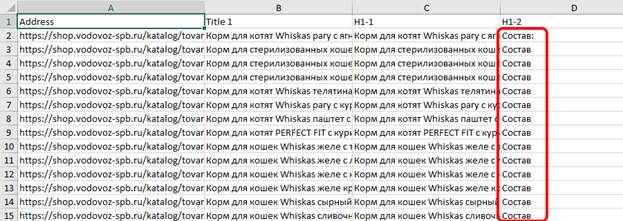

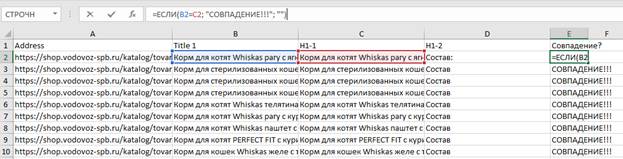

Вот так выглядит выгруженная из Screaming Frog Seo Spider таблица:

Что же мы видим по таблице?

1) часть страниц не индексируется, о чем свидетельствуют записи “Non-Indexable” и “noindex”, следовательно, эти страницы нужно убрать из таблицы, чтобы они не мешали дальнейшему анализу;

2) не индексируются именно те страницы, которые лишены заголовков Title;

3) на многих страницах очень короткий Title (см 4 и 5 столбцы, где указана длина Title в символах и в пикселях соответственно).

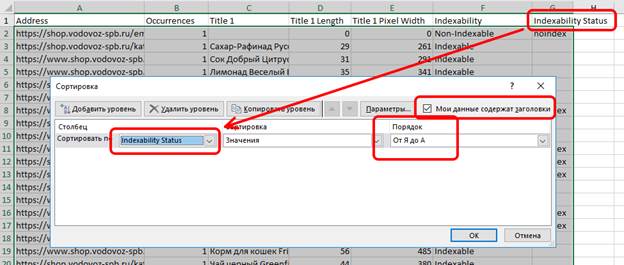

Итак, чистим таблицу от мусора:

1) удаляем первую строку, чтобы Excel не воспринимал ее содержимое, как заголовок таблицы;

3) выделяем все строки с неиндексируемыми страницами и удаляем их – их анализировать бессмысленно;

4) повторяем пункт 2), но на этот раз сортируем не по последнему столбцу, а по первому – это необходимо для того, чтобы все адреса с www. были вверху таблицы, затем также выделяем эти строки и удаляем их – ранее мы про эти дубли уже занесли информацию в аудит, а потому на данном этапе все www.-страницы нам будут сейчас только мешать;

5) снова сортируем таблицу, но уже по столбцу Title – это необходимо для того, чтобы адреса с одинаковыми Title были рядом друг с другом.

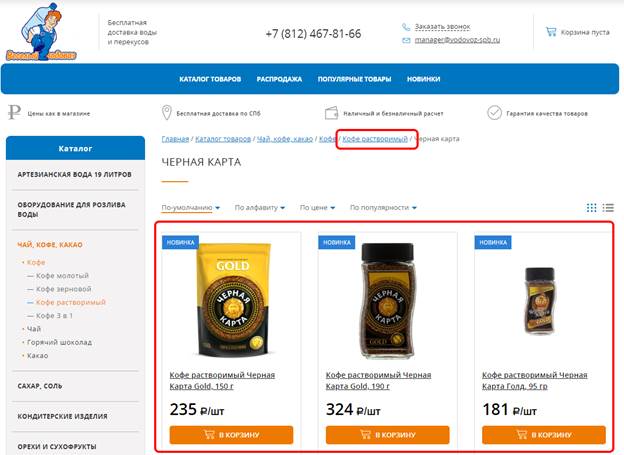

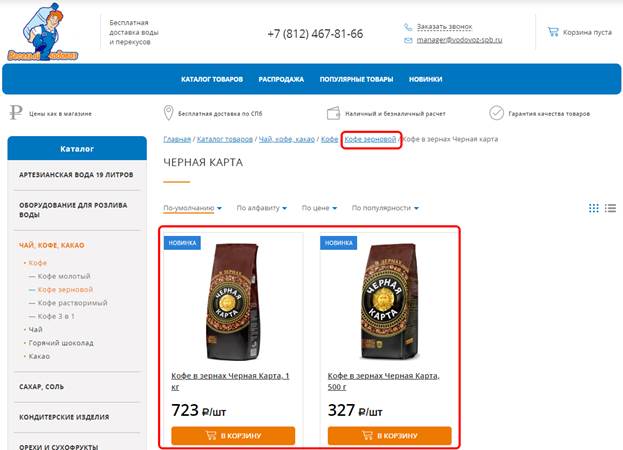

Упс… А странички с одинаковыми Title-то присутствуют!

Остается только выяснить, являются ли эти дубли документальными. Единственный способ проверить – вручную зайти на каждый из двух адресов, и…

… и, как видим, контент на них отличается. Следовательно, это не документальные дубли.

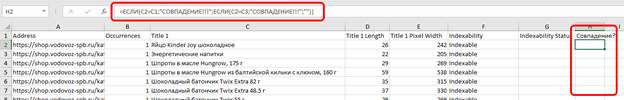

И вот сейчас многие зададут вопрос – а что делать, если в таблице несколько тысяч адресов, больше половины из которых с совпадающими Title’ами? Как их быстро «выстроить»? Очень просто – с помощью Excel’евской формулы «если».

Что делает данная формула? Допустим, у нас в ячейке C2 присутствует Title. Формула сверяет значение этой ячейки с ячейками на позицию выше и на позицию ниже (т.е. C1 и C3 соответственно). Если совпадение есть – формула так и скажет, мол, СОВПАДЕНИЕ. А если нет – промолчит. Теперь осталось «растянуть» эту формулу до конца таблицы.

Ну а теперь сортируем таблицу по значениям последнего столбца от Я до А, тогда все адреса с одинаковыми Title’ами окажутся сверху. Упс… А совпадений-то много, однако!

А это значит, что проверка на то, какие из этих страниц являются документальными дублями, займет некоторое время. Однако, в реальной жизни получение этого списка – дело 1-2 минут после окончания сканирования сайта. Ничего себе?

Спойлер: в данном случае документальных дублей не было (если не считать страницы с www. в начале адреса).

Вот такими нехитрыми манипуляциями мы буквально за пару минут выяснили, что:

Про последний пункт в статье ничего не говорилось, да и говорить особо нечего: если Title слишком длинный, то можно попробовать его сократить (если, конечно, есть возможность), а если слишком короткий, то его можно расширить дополнительными ключевыми словами.

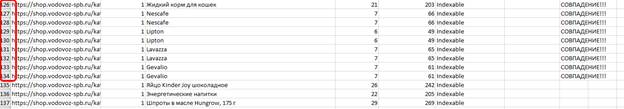

Поиск страниц с совпадающими Title и H1

Как Вы уже знаете из прошлых статей, совпадение мета-тега Title и заголовка H1 в SEO не допускается. Однако, данное явление не является редкостью. Иногда это сделано потому, что заказчик «я сказал делаем так – значит делаем так», но нередко это бывает из-за технических ошибок. В любом случае это не нормально. И снова с помощью Screaming Frog SEO Spider эти страницы (после сканирования) можно найти всем скопом в пару кликов, а именно:

Далее экспортируем данные в эксель, открываем и удаляем из таблицы все столбцы, кроме:

Остальные столбцы нам на данном этапе не нужны. Момент с удалением www.-дублей тоже пропустим, впрочем, как и момент удаления неиндексируемых страниц.

Далее сортируем «от Я до А» по столбцу H1-2 – это необходимо для того, чтобы быстро выявить страницы, на которых более одного заголовка H1. Кстати, рекомендуется их отделить от остальных страниц пустой строкой.

Далее в последнем столбце с помощью оператора =если формируем формулу, которая нам сообщит, в каких именно строках Title совпадает с H1:

В пределах скриншота совпадения, увы, есть везде. Но ТОЛЬКО в пределах скриншота. Последний штрих – сортируем «от Я до А» по последнему столбцу, чтобы переместить в самый верх таблицы строки, в которых совпадают Title и H1. В реальной жизни эта процедура занимает буквально 2-3 минуты, не более.

По последнему скриншоту видно, что:

Как видите, с точки зрения SEO на сайте всё очень плохо. А ведь нам это всё придется исправлять…

По дублям закончили.

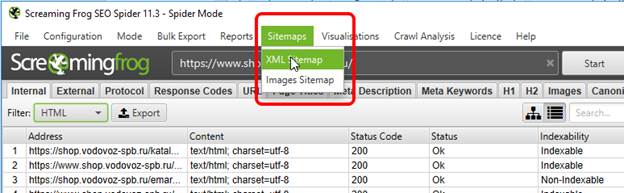

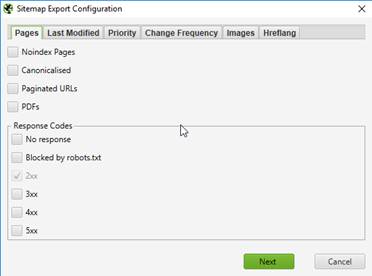

Как сгенерировать Sitemap.xml

Sitemap.xml на нашем сайте уже давно разжеван вдоль и поперек, поэтому мы не будем снова рассказывать о том, насколько он важен, чем полезен и т.д. Но что делать, если его нет, а настроить его автоматическое генерирование средствами сайта не получается? Правильно – придется генерировать вручную. Но имейте в виду, что необходимо, чтобы robots.txt уже присутствовал на сайте и был составлен правильно – это необходимо для того, чтобы «ненужные» страницы не попали в sitemap.xml. К делу.

Итак, сайт уже просканирован, потому заходим в меню Sitemaps и выбираем XML Sitemap.

В открывшемся окне… короче, можно оставить все настройки по умолчанию и вообще ничего не трогать. Ну… Самый максимум – можно еще поставить галочку “Canonicalised”, что в большинстве случаев это бессмысленно, либо поставить галочку “PDFs” (например, если у Вас прайс-лист оформлен именно в этом формате).

Теперь дело за малым – нажать на кнопку Next, сохранить сгенерированный Sitemap.xml, закинуть его на сайт и (при необходимости) скорректировать на него ссылку в robots.txt. И, вроде бы, всё здорово, но есть еще один важнейший момент… В случае с нашим клиентом такой подход будет… НЕПРАВИЛЬНЫМ, поскольку присутствует большое количество www.-дублей и все они пойдут в sitemap.xml, а это не есть хорошо. В данном случае необходимо:

Именно в такой последовательности.

С картой сайта, будем считать, разобрались.

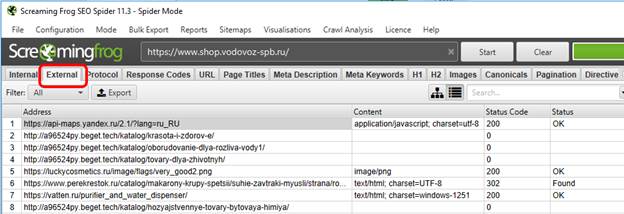

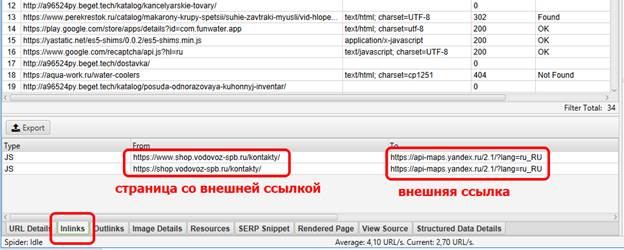

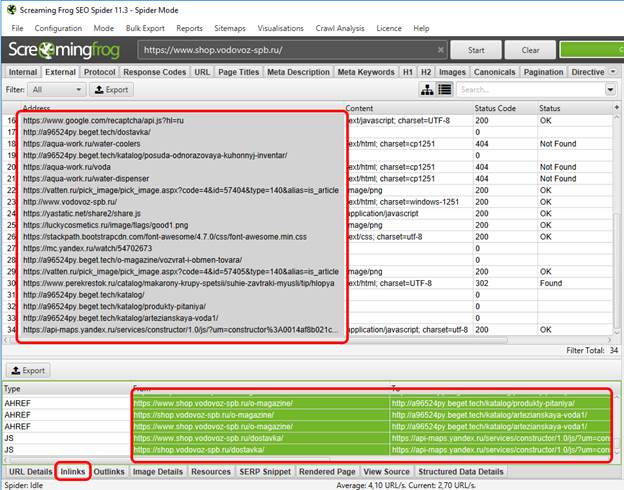

Поиск внешних (исходящих) ссылок

Про внешние ссылки уже тоже было многократно рассказано, поэтому сейчас не будем опять заострять внимание на то, когда внешние ссылки можно «оставлять открытыми», а когда нужно закрывать.

Собственно, внешние ссылки после сканирования сайта даже выискивать не нужно – Screaming Frog SEO Spider выносит их на отдельную вкладку – “External”.

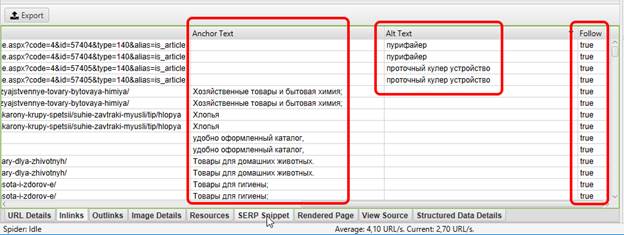

И вот тут, казалось бы, все просто – экспортируем список внешних ссылок, добавляем их в аудит и всё! Но возникает вполне логичный вопрос – ОК, список внешних ссылок мы нашли, но как их искать в пределах сайта? Как узнать, на какой странице располагается вот эта конкретная внешняя ссылка? Очень просто – в самом низу будет вкладка “inlinks”, в которой будет отражена данная информация:

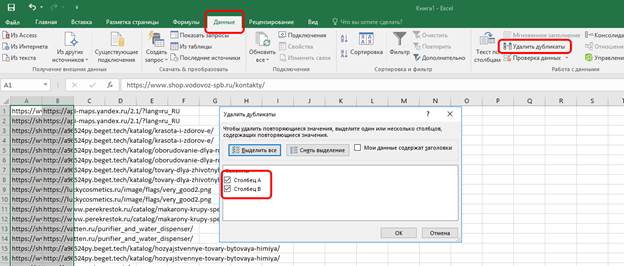

В данном случае у нас чуть более 30 внешних ссылок. Вручную заносить в аудит информацию о том, где каждая из них располагается – это тот еще садизм, поэтому мы поступаем по-хитрому, а именно:

1) выделяем все внешние ссылки, указанные в программе;

2) целиком выделяем столбцы “From” и “To”;

3) копипастим эти 2 столбца в эксель;

4) чистим строки от дублей (на всякий случай).

Полученные результаты сохраняем в отдельный эксель-файл и ссылаемся на него в аудите. В данном случае количество строк превысило 36000. Такое бешеное количество строк связано с тем, что большинство внешних ссылок (если не все) являются «сквозными», т.е. находятся на каждой странице сайта (например, в подвале, шапке и т.д.). Следовательно, если убрать одну такую «сквозную» ссылку – таблица резко похудеет на несколько тысяч строк. Не отрицаем, данный подход, мягко говоря, не слишком удобен, но зато так куда сложнее что-то упустить.

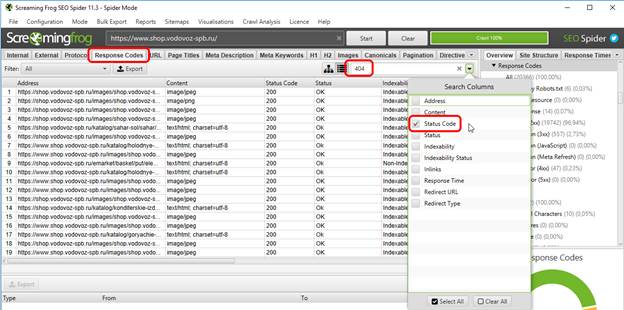

Поиск битых ссылок

Про битые ссылки тоже уже не раз рассказывалось на нашем сайте, поэтому останавливаться на теоретической части и рассказывать в очередной раз о том, что битые ссылки необходимо либо исправлять/удалять/переадресовывать [нужное подчеркнуть] не будем и перейдем к практике.

Первым делом переходим на вкладку “Response Codes” (это необязательно, просто вкладка “External” гораздо сильнее нагружена информацией, которая для поиска битых ссылок один фиг не используется). Далее в поиске ставим галочку Status code и в поле поиска вводим всеми нами любимое число 404.

После этого у нас в таблице остаются только битые ссылки, причем как внешние (исходящие), так и внутренние. Как выискивать их расположение на сайте? Ровно так же, как и внешние:

И теперь ровно по той же схеме удаляем повторяющиеся строки и www.-дубли через эксель. Всё – профит!

Хотя, ради справедливости, отметим, что после столбцов “From” и “To” есть и другие. Например, столбец, в котором будет показан текст анкора (если ссылка анкорная), текст тега alt (всплывающая подсказка при наведении) и даже информация о том, является ли это ссылка dofollow (true), либо nofollow (false).

Однако, информацию из этих трех столбцов мы в аудит уже не добавляем – нет необходимости.

Итоги

Вот такой вот получился обзор на «лягушку-скримера». По секрету скажем, что здесь перечислено далеко не всё, что было добавлено в аудит и далеко не всё, что было экспортировано для добавления в тот же аудит. Тем не менее, даже при таком раскладе Вы убедились, что программа крайне полезная в плане диагностики сайта.

Еще раз – что мы сделали:

Теперь осталось решить самый важный вопрос – а стоит ли платить за эту программу? А вот теперь давайте по-честному.

Если у Вас очень небольшой сайт, то Вам лимита в 500 УРЛ и урезанного функционала на первое время хватит, ибо его достаточно, чтобы выявить «общие» проблемы сайта.

Если же Вы используете Screaming Frog SEO Spider в коммерческих целях (например, для проведения аудита клиентского сайта), то тут имеет смысл поддержать разработчиков финансово. Да, лицензия стоит немало – 149 фунтов, что в пересчете на рубли – примерно 13-13,5 тысяч, причем это цена за год, а не за лайфтайм. Но подумайте вот о чем: 13500 в год = чуть более, чем 1100 рублей в месяц, а теперь вспомните, сколько стоит аудит – минимум в 7-8 раз дороже, а то и в 10, а то и в 15, а сколько таких аудитов Вы делаете в месяц? Ну а если Вы все-таки решили зажать для разработчиков эти 13,5 килорублей, то… Вы знаете, что делать.